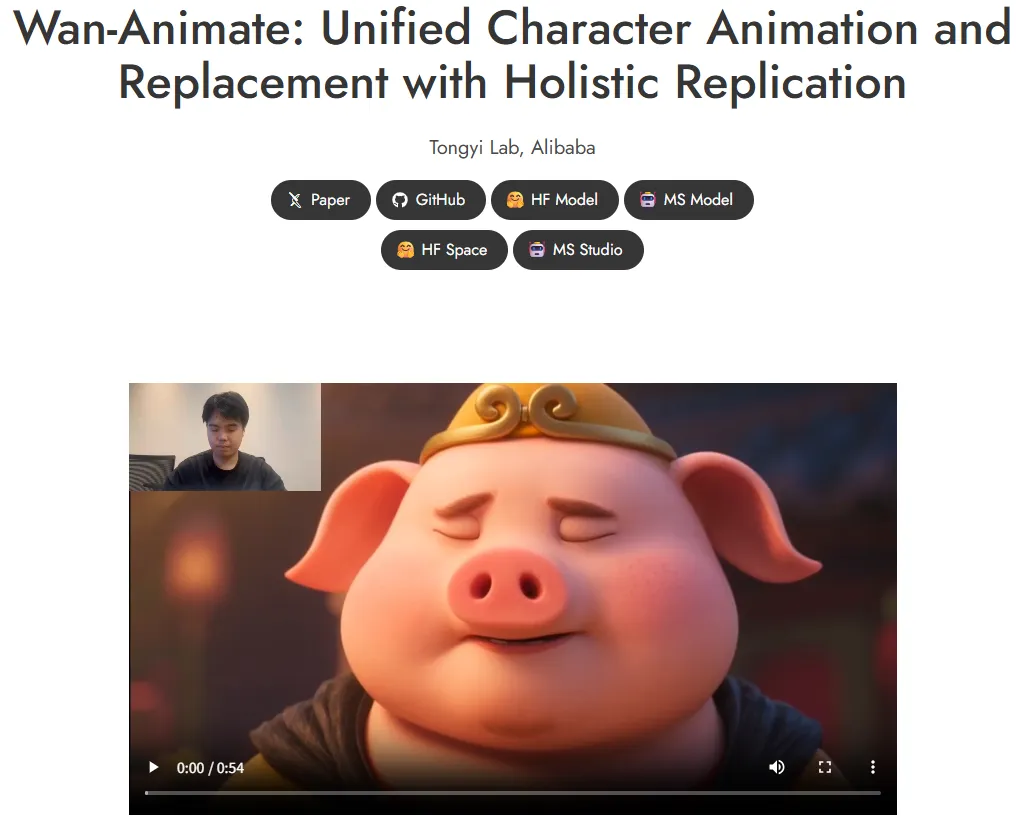

動画制作で「俳優の演技を別キャラクターに乗せる」「既存の人物を差し替える」作業は、撮影やモーションキャプチャ、合成など複数工程に分かれがちです。Wan 2.2 Animate 14Bは、キャラクター画像1枚と参照動画1本を入力するだけで、口元・視線・身体の動きを一括で生成するAlibabaのオープンソースモデルです。2025年9月にモデル重みと推論コードが公開され、ローカルでもクラウドでも利用できるようになりました。

本記事では、Wan 2.2 Animate 14Bの仕組み、2つのモード、料金と導入フロー、ビジネス活用のポイント、留意すべきリスクを整理します。

目次

Wan 2.2 Animate 14Bとは

Wan 2.2 Animate 14Bは、キャラクター画像+参照動画という入力で新規動画を生成するモデルです。参照動画のモーションをキャラクターに付与して躍らせることも、既存動画の人物をキャラクターに置き換えることも可能で、従来別タスクだったポーズ転写やフェイスリプレイスをひとつのフレームワークに統合しています。

モデル重みと推論コードはApache 2.0ライセンスで公開され、ローカル推論に加えて wan.video や Hugging Face Space、ModelScope などのWeb環境でも試せます。

技術と特徴

- キャラクターアニメーションと人物置換を単一モデルで実装

- 入力画像の特徴と参照動画の動きを統合し、照明や色調も自動で整合

- Apache 2.0のオープンソース公開でカスタマイズやローカル運用が容易

2つのモード(Animation/Replacement)

| モード | 入出力 | 想定シーン |

|---|---|---|

| Animation(Move) | 画像のキャラクターが参照動画の動き・表情を再現 | 静止画ベースの演技付け、CGキャラの告知動画、ポーズ量産 |

| Replacement(Mix) | 参照動画の人物をキャラクターに置換し照明・色を馴染ませる | 既存映像の出演者差し替え、フェイス/ボディのデジタルダブル |

大規模モデルを効率的に動かす仕組み

Animate 14Bは高ノイズ段階と低ノイズ段階それぞれに約14Bパラメータのエキスパートを持つMixture-of-Experts構成です。各ステップで片方のみを活性化するため、総容量は27B相当でも推論計算とVRAM負荷は14B級に収まります。FSDP+DeepSpeed Ulyssesやオフロード設定でさらなる省メモリ化も可能です。

破綻を抑えた表現力を支える工夫

GitHubの推論スクリプト、Hugging Face SpaceのWeb UI、ComfyUI/Diffusers連携が同時に提供され、デザイナーでも扱いやすいI/Oが整備されています。また Wan 2.2世代で画像+65.6%、動画+83.2%規模を拡大し、照明・構図・色調などの美的ラベルを細かく付与したことで、動きの大きいショットから微細な表情まで破綻を抑えて出力できます。

提供形態と料金体系

| 形態 | 入手先 | 料金の考え方 |

|---|---|---|

| オープンソース(ローカル実行) | GitHub / Hugging Face | Apache 2.0で無償。GPUなど計算資源は自前準備 |

| Webデモ/ホスティング | wan.video、Hugging Face Space | デモ枠は無料(混雑状況により変動) |

| クラウドAPI(参考) | Alibaba Cloud Model Studio | モデル単位の従量課金。wan2.2-s2v例:480p約$0.0717/秒、720p約$0.129/秒。Animate専用の最新レートはModel Studioを確認 |

ローカル=ライセンス無償、クラウド=秒課金という構造なので、案件規模やリードタイムに応じてハイブリッド構成を選べます。

利用方法

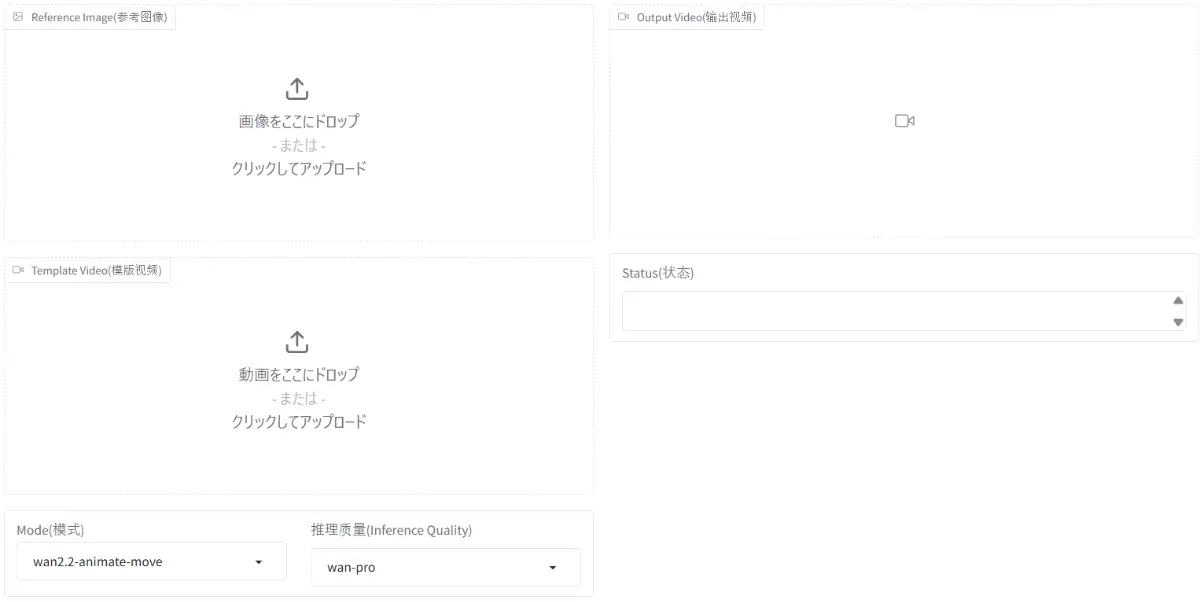

Webで試す

- Wan2.2-Animate Spaceにアクセス

- キャラクター画像と参照動画をアップロード

- Animation/Replacementを選択し実行

- 完了後プレビューし、必要ならダウンロード

ローカルで回す

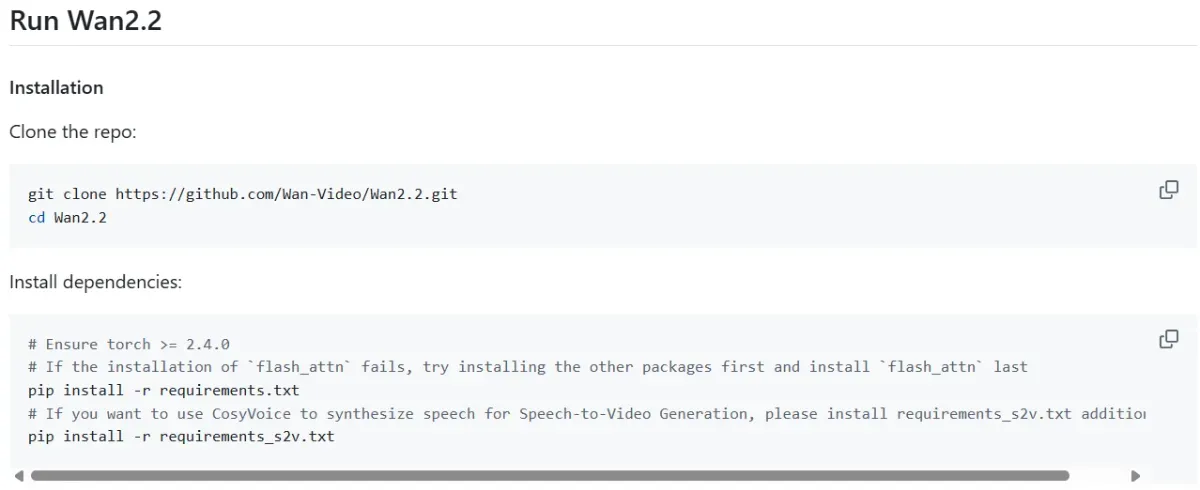

- GitHubリポジトリをクローン

requirements.txtをインストール- 前処理スクリプトで画像・動画から必要素材を抽出

generate.pyをモード別に実行。VRAM不足時はオフロードやFSDPを有効化- 代表コマンドは README の “Run Wan2.2 Animate” に掲載

引用:https://github.com/Wan-Video/Wan2.2/blob/main/README.md

引用:https://github.com/Wan-Video/Wan2.2/blob/main/README.md

ビジネス活用の可能性

-

キャラクターの演技付け動画を短時間で量産

静止画ベースのキャラクターに別撮りの出演者の演技を移し、短尺SNS告知やPR動画を素早く作成できます。Animationモードが有効です。

-

既存映像の出演者差し替え

撮り直しが難しい映像でも、Replacementモードで人物を置換し照明や色を馴染ませられます。デジタルダブルや多言語展開の補素材にも向きます。

-

最新デモを参照してワークフロー設計 公式デモ(https://humanaigc.github.io/wan-animate/)には素材選びやモード設定の例が随時追加されるため、社内テンプレート作成時のガイドになります。

導入時に確認すべきこと

- ライセンスと規約:Apache 2.0にも禁止事項が記載されているため、用途や公開範囲に照らして確認

- 入力素材の権利:参照動画・キャラクター画像の著作権/肖像権/商標を確実にクリアし、管理台帳を残す

- 品質確保:顔が小さすぎる素材や極端な動きは破綻の原因。解像度やフレーミングを調整し、必要に応じてリライティングLoRA等を追加

- 運用設計:ローカルGPUのキャパシティ、FSDP設定、クラウド併用時の課金管理を事前に計画

注意すべきリスク

- なりすまし/誤認の回避:実在人物の演技を模倣する場合は本人同意と用途表示を徹底し、配信時のクレジットやメタデータで合成であることを明示

- プラットフォーム規約:SNSや広告プラットフォームの合成コンテンツポリシーを確認。違反すると配信停止になる可能性

- セキュリティ/コスト管理:クラウドAPI利用時は鍵管理とアクセス制御を徹底。従量課金なのでタスク量を見積もり予算化する

まとめ

Wan 2.2 Animate 14Bは、画像1枚 + 動画1本からアニメーションと置換を作り分けられる統合フレームワークです。二段MoEで高品質を維持しつつ推論負荷を抑え、オープンソースとクラウドAPIの両輪で導入できます。短納期の動画制作や出演者差し替えといった現場ニーズに直結するため、まずはHugging Face Spaceで挙動を確認し、要件に応じてローカル実行やクラウド運用に展開する流れが実務的です。